微软刚刚将其最新的AI集成到其更广泛的产品生态系统中,从Bing搜索到办公室

,甚至可能是Windows本身:类似于Chatgpt的AI系统

,可以通过大型语言模型与用户进行交互,该公司表示

,该公司将大大增强搜索结果和使用其产品的一般用户体验。

在99.9999%的情况下

,这可能是正确的,但是总是使您陷入困境的边缘案例

,而实际上是黑匣子的系统的失败是不可避免的

。Google和Microsoft对这个想法的努力非常震惊

,因为它们在互联网上具有独特的特权,以至于我们其他人没有

。

但是 ,随着这些新的AI工具的集成

,Google,Microsoft和其他人几乎都将保护抛弃了,因此

,他们可以并且应该对他们的新聊天机器人产生的每一个错误信息和诽谤都承担法律责任。

你可能喜欢

幻觉在chatgpt中下降

,但这并不是我们AI问题的终结

Meta‘我的书训练它的ai–但是有一个更大的问题

AI版权难题

为无休止的诉讼奠定基础

根据记录,请务必在开始任何锻炼计划之前咨询医疗专业人员

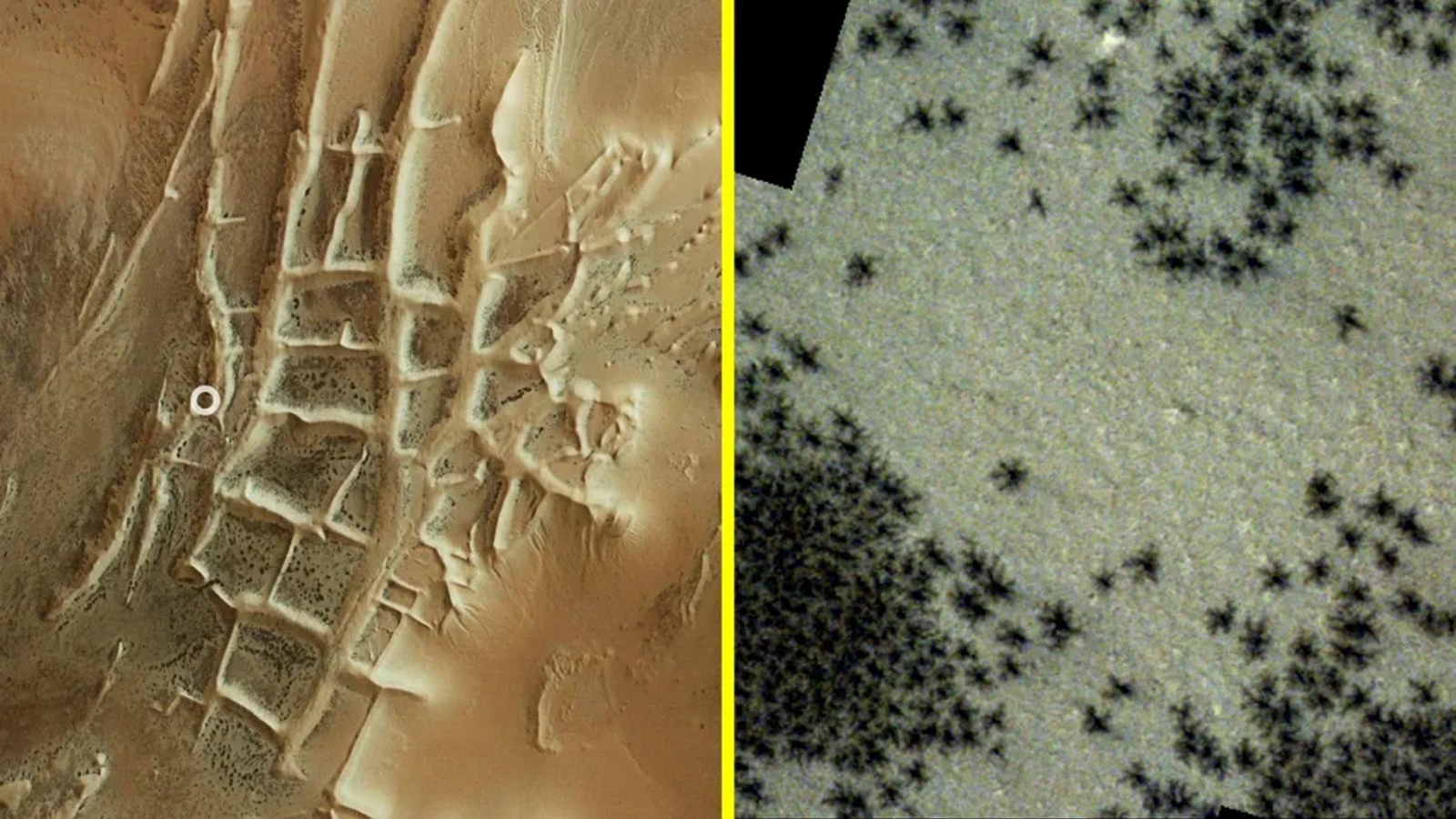

。(图片来源:微软)

向任何YouTube创建者或印刷或在线记者询问版权

,您一定会了解公平使用

,引用材料,“背景”以及所有其他规则的规则

,这些规则涉及他们可以发布的内容以及如何发布

。

如果您正在直播Hi-Fi Rush而忘记打开直播音频选项?享受您帐户上的版权罢工。忘了将文章中的整个文本词归因于原始来源?在随后的窃争议之后

,请带来乐趣在写作生涯中(并准备放弃,如果案件充满了案件

,就可以放弃任何利润)

。

当Black-Box AI“无意中

”窃您的材料并出版了盈利时

,会发生什么?或者,如果它从网站上删除了不良建议或重新介绍其刮擦的材料 ,但省略了至关重要的

,法律要求的免责声明怎么办?如果它做了数千万次或数百万次会发生什么?这些AI聊天机器人的全部目的是它们是自主的,因此在聊天机器人说合法问题之前,几乎没有任何干预的机会

。

即使在微软自己的新闻材料中

,它也包括新的Bing聊天功能的屏幕截图

,其中提示“让我可以在家中锻炼

”的提示在没有任何医疗免责声明或背景下,就对某些练习时有任何严重伤害的风险提供了答案。

这是人身伤害律师谋生的事情

,这些聊天机器人由世界上最富有的公司部署

,这将是绝对不可抗拒的目标 。

值得称赞的是,微软Bing的AI驱动聊天机器人至少会为它获得用于生成答案的材料的何处提供引用

,但是作为一名记者

,我可以告诉您:“好吧,这是我从那里得到的合法抗拒的材料

。”

当平台成为发布者时

(图片来源:Google)

新的Bing所产生的产品只会像它作为输入的数据一样好

,并且通过在聊天中重写它

,而不是简单地传递其他人所写的内容(就像Google和Microsoft现在的搜索结果一样),即使他们将其他人的作品引用了其他人的来源 ,他们最终还是成为该内容的发布者。

您可以介绍最先进的过滤器以最大程度地降低风险

,但是在某些时候,其中一个聊天机器人将响应一个非常具体的提示,并从一些非常可疑的来源中提取

,这将带来违反法律甚至造成伤害的结果。谁负责?

如果Microsoft Bing建议在食谱中替代鸡蛋(Microsoft本身说

,新的Bing将能够在其演讲中做到),并向患有过敏的人推荐一种成分

,应该责怪该人生病或上帝禁止的

,实际上是因为生病的,实际上是一个死亡?您可以打赌

,将有一组律师大军

,他们将迅速解决这个法律问题,而微软将在其自己的聊天机器人制作出犯罪的工作时会更加困难地隐藏并声称“平台

”豁免

。

更糟糕的是

,微软没有人能够预测何时会发生这种情况以及有问题的材料会发生什么

,因此无法防止它

。这是因为从根本上说,没有人知道这些生成的AI模型实际上是如何得出的 ,因为神经网络在很大程度上是黑匣子。您无法预测每个问题

,只能在事实之后识别出来,这对于以公共面向公共方式实施这些模型的大型科技公司来说不会是一个很好的法律辩护

。

(图片来源:未来)

他们最终将不可知的责任纳入他们的产品并对其产生的产品负责,就像我写信的techradar(和母公司Future Plc)将承担责任

,并且发表了一些造成伤害或违反某个国家法律的东西

。

有关键的保障措施

,以确保当您是出版商时不会发生这种情况(例如编辑,并且需要在此类事情上为作家进行法律培训)

,但是Microsoft和Google似乎准备让他们的AIS在互联网上放松

,而无需在用户界面的任何跨越人类的人体监督下进行。祝你好运

。

所有公司的微软都应该知道这可能是如何结束的,因为它的实验性Twitter Chatbot Tay在不到一天的时间内被互联网用户劫持了

,他们将其变成了一个肮脏的顽固派

。当然

,自从泰伊(Tay)否认大屠杀以来的七年中,AI的状况已经走了很长一段路

,但老实说

,它并没有从根本上改变。这些模型像以往一样有偏见和容易受到操纵,现在它们看起来更加复杂 ,以使他们的缺点更好地隐藏

。

How much of a legal shield that will be for Big Tech companies rolling out AI models online that are intrinsically capable of spreading legally damaging misinformation and libel remains to be seen, but March 2016 was also a very different era for tech than 2023, and something tells me that people nowadays are going to be far less forgiving no matter what your politics happen to be (Editor's update: this week, Alphabet livestreamed a demonstration of Google's Bard AI并实时展示了一种实际上是不正确的反应

。

自我造成的生存危机

(图片来源:未来)

成为出版商的法律危险是无限的

,就像有些方法是撒谎某人或传播危险的,无保护的演讲,因此无法预测AI整合的破坏性。

我所知道的是Google

,Microsoft和其他任何大型技术平台

,这些平台认为它将跳上AI作家的潮流,最好准备回答任何不可避免地会出现的东西

,并且在不可避免的情况下

,经验丰富了这些自动化语言模型,一旦这些自动化的语言模型

,一旦有数百万甚至数十亿人与他们互动

,那么这些模型就可以很快地与他们互动 。

如果我们在过去几年中学到了一件事,那就是在每个受过互联网培训的AI模型中

,就有一个非常偏执的

,对种族灭绝的巨魔,他们正在寻找一些可以抓住的裂缝

。那么 ,要爬进我们的聊天引擎结果多长时间?其中有多少将是合法行动的?

谁说

,但是在任何世界上,我都不会敢打赌我万亿美元的公司在这个短暂的事物上的存在。但是,鉴于Big Tech的绝对偏执狂错过了下一件大事

,即使这是Big Tech的最鲁ck的举动

,也不令人惊讶的是。

正文

Chatgpt是Microsoft和Google的生存危机,但并非以他们认为的方式

文章最后更新时间2025年06月14日,若文章内容或图片失效,请留言反馈!

-- 展开阅读全文 --